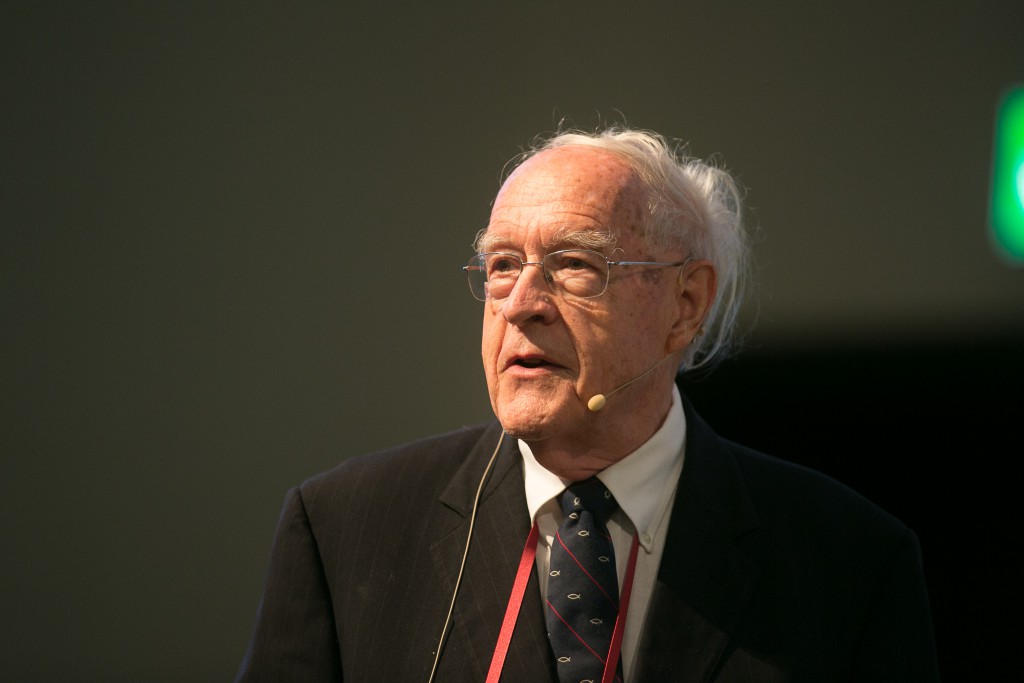

Computergeschichte(n) aus erster Hand: Fred Brooks

BLOG: Heidelberg Laureate Forum

Wir können die Herren Daimler und Benz nicht mehr direkt über ihre Erfahrungen mit den ersten Automobilen befragen. Computer sind dagegen zumindest soweit jüngeren Datums, als dass eine Reihe der Pioniere dieser Technik noch leben – und da diese überlebenden Pioniere, wenig überraschend, hochdekoriert sind, bietet das Heidelberg Laureate Forum gute Gelegenheiten, Computergeschichte(n) aus erster Hand zu hören.

So am Montag, wo ich in der beachtlichen Mittagessen-Schlange mit Fred Brooks zusammenstand, der als IBM-Mitarbeiter in den 1960er Jahren eine ganze Reihe von Entwicklungen – damals die großen Mainframe-Rechner betreffend – mitbekommen hat. Heute, am Dienstag, hat Brooks dann noch einen Vortrag “A personal history of computers” gehalten. Für mich waren Gespräch und Vortrag immer dann am spannendsten, wenn ich merke, dass irgendetwas, das aus heutiger Sicht selbstverständlich ist, damals durchaus zur Debatte stand – und die Entscheidung durchaus auch anders hätte ausfallen können.

Dass ein Byte acht Bit besitzt, hielt ich bislang für natürlich, insbesondere weil 8 ja eine Zweierpotenz ist. Tatsächlich war diese Festlegung aber eine geschäftliche Entscheidung aus den 1960er Jahren, mit guten Argumenten dafür, aber auch guten Argumenten dagegen, sprich: für die Beibehaltung des bis dahin genutzten Byte mit nur sechs Bit. Einige gewichtige Gründe waren wirtschaftlicher Art, verlangte die Umstellung es doch, eine beachtliche Menge an Hardware zu ersetzen – von Bandspeichern, die bis dahin nur sieben Spuren gehabt hatten (sechs Bit plus ein Bit zur Kontrolle) auf neunspurige Magnetbänder bis hin zu Druckern. Gesamtkosten im mehrstelligen Millionenbereich. Aber auch vom wissenschaftlichen Rechnen her gab es gute Argumente gegen die 8 Bits. Vier Bit-Rechnungen waren nicht genau genug, 8-Bit-Rechnungen dagegen für die damaligen Erfordernisse eher schon zuviel; 6 Bit dagegen schienen ein guter Kompromiss. Andererseits konnten 8 Bit deutlich mehr verschiedene Zeichen repräsentieren – und insbesondere, wo nötig, zwei Dezimalziffern auf einmal.

Am Ende traf Brooks eine Geschäftsentscheidung für die 8-Bit-Variante. Das führte zu heftigen Diskussionen insbesondere mit Gene Amdahl, dem Architekten von dem, was IBMs erstes für wissenschaftliche und kommerzielle Anwendungen gleichermaßen nutzbares System werden sollte. Am Ende des entsprechenden Tages reichten Brooks und Amdahl unabhängig voneinander die Kündigung ein – um dann von einem der IBM-Spitzenmanager, der die Wogen glätten konnte, gleich wieder eingestellt zu werden. Für Brooks waren die 8 bit seine für die Welt der Computer folgenreichste Entscheidung.

Apropos Dinge als selbstverständlich ansehen: Computer, die universell einsetzbar sind, nicht für eine bestimmte Anwendung maßgeschneidert? Ebenfalls eine Geschäftsentscheidung. Und bei den großen Schüben der Computeranwendung fällt bei Brooks mehrfach die Formulierung, “jetzt sei das Kamel im Zelt” – für ein Modell war es der Zeitpunkt, als der Computer billiger wurde als die vier spezialisierten Buchhaltungsmaschinen, die er ersetzen sollte; war er erst einmal da, wurde er aber selbstverständlich auch anders genutzt. Bei einem anderen Übergang waren es die Computer, die klein und preiswert genug wurden, um zur Steuerung wissenschaftlicher Instrumente dienen zu können. Wo die Universität vorher Schwierigkeiten gemacht hatte, wenn der Fachbereich sich einen Computer anschaffen wollte, welcher dann dem Universitätsrechenzentrum Konkurrenz gemacht hätte, war es auf einmal OK, eine “Kontrolleinheit” für bestimmte Instrumente zu erwerben – nur, dass die Kontrolleinheit nachher natürlich auch für ganz andere Dinge genutzt wurde.

Textverarbeitung? Das erste Beispiel, das Brooks einfällt, stammt aus einer Zeit, als der reine Rechenaufwand so enorme Kosten mit sich brachte, dass an eine Anwendung wie Textverarbeitung eigentlich nicht zu denken war – bis auf die eine Ausnahme: Während der Entwicklung eines neuen Computersystems, wo der Umstand, dass es nun möglich war, die jeweils aktuelle Form der Gebrauchsanweisung bereits am nächsten Tag ausgedruckt vorliegen zu haben, beachtliche Vorteile für das Entwicklungstempo mit sich brachte.

Höhere Programmiersprachen? Auch das ein Kampf, der erst gewonnen wurde, als demonstriert werden konnte, dass die kompilierten Programme auch nicht weniger effizient waren als die von menschlichen Programmierern maßgeschneiderten. (Das war, natürlich, zu einer Zeit, als Rechenzeit extrem teuer war – über die in dieser Hinsicht oft genug verschwenderischen Programme von heute würden die damaligen Programmierer nur den Kopf schütteln können.)

Einige Elemente von dem, was Brooks erzählt, sind allerdings auch in heutiger Zeit noch unangenehm aktuell – der sechswöchige Studienaufenthalt für wichtige IBM-Mitarbeiter bei der National Security Agency etwa, der sicherstellen sollte, dass IBM die Anforderungen der NSA bei zukünftigen Entwicklungen angemessen berücksichtigen konnte.

Insgesamt ist die Geschichte des Computers ein wichtiger Teil sowohl unserer kulturellen als auch unserer technischen Vergangenheit, und es ist faszinierend, sie sich von denen erzählen zu lassen, die damals mit dabei waren. Und dank der eifrigen mit Videoaufnahmen beschäftigten HLF-Helfer kann jeder, der einen geeignet ausgerüsteten Computer besitzt (8-Bit-Bytes und noch ein paar weitere Anforderungen) den Vortrag von Brooks hier online selbst anhören und -sehen.

Schon Zuse’s Z3 war Turing vollständig (konnte also alles berechnen was berechenbar ist), hatte eine Gleitkommaeinheit und einen Speicher in dem Daten und Programme zugleich abgespeichert waren. Überhaupt überrascht wie früh schon die grundlegenden Prinzipien und Architekturen von Computern ausgearbeitet wurden.

Aus höherer Warte betrachtet hat ein laufender Computer Ähnlichkeit zum Prozess, welcher das biologische Leben ausmacht, dem Prozess nämlich, der ständig “Programme” aus der DNA ausliest und diese Programme – über Zwischenstufen – in Proteine und DNA-Aktivierungen übersetzt. Auch dieser Prozess ist konzeptionell genau so einfach wie ein Computer. Die Komplexität entsteht erst über die Software und über Reflexivität (hier noch auf der Stufe der Rekursivität), also den Fakt, dass Programme die Ausführung von Programmen bestimmen.

Der nächste grosse Schritt, der in den Computerwissenschaften ansteht, ist es, den Systemen Reflektivität auf einer höheren Ebene zu verleihen. Reflexivität nämlich, die Computer wissen und verstehen lässt, was sie tun und warum sie es tun. In der Geschichte des Lebens dauerte es hunderte von Jahrmillionen bis es mit dem Menschen als intelligentes Wesen so weit war und bis dieser Mensch Maschinen schaffte, die das Potenzial haben, sich irgendwann selbst als Objekte und Subjekte wahrnehmen zu können. Mit dem Menschen und seiner Zivilisation als Basis sollte es nur noch einige Centennien oder gar nur Dezennien dauern, bis die vom Menschen geschaffenen belebten Maschinen (Computer/Roboter) ebenso weit sind. Und um den Gedanken weiterzuspinnen: Vielleicht werden ja “beseelte” Roboter wiederum Nachfolger ihrer selbst erschaffen; Nachfolger, die nicht mehr in Fabriken zusammengebaut werden, sondern die sich selbst reproduzieren. Womit sich der Kreis geschlossen hätte.

Eine Vision, die ich ganz und gar nicht teile!

Eine KI die wirklich versteht, was sie tut, so wie wir Menschen auch, halte ich mittelfristig für grundsätzlich schädlich für die Menschheit und langfristig auch nicht für besonders erstrebenswert.

Ja, sogar KI-Forscher warnen ja beispielsweise vor autonomem Waffensystemen. Andererseits, ein Roboter, der nicht weiss was er tut hat nur beschränkte Einsatzmöglichkeiten. Ähnlich wie ein Mensch, der nicht weiss, was er tut und wozu, seine Arbeitseeise nicht verbessern kann. Man kommt also gar nicht darum herum, computern und Robotern ein gewisses Verständnis mitzugeben für das was sie tun.

Doch! – Man muss zuerst einmal die Menschen und zwar alle ohne Ausnahme dazu bringen, zu verstehen was sie tun oder besser nicht tun sollten und warum sie etwas nicht tun sollten. Und man muss den Menschen beibringen, wie Maschienen eingesetzt werden können oder besser nicht, was nach meinem Eindruck derzeit eher selten stattfindet. KIs, wie sie in der SF vorkommen, etwa Commander Data aus Star Trek, Rommy aus Andromeda oder C3PO und R2D2 aus Star Wars sind mit bisheriger Technik absolut unrealistisch, und daran wird sich vorläufig bis mittelfristig auch nichts ändern. Ausserdem besteht ja immer noch die Gefahr, dass sich die KIs denn doch mal gegen ihre erschaffer, also die Menschen wenden könnten. Diese Gefahr lässt sich auch nie ganz ausschliessn. Schon gar nicht, wenn die Systeme so unüberschaubar werden, das ein Mensch sie per se nicht mehr überblicken kann. Das ist bei vielen Systemen ja heute schon der Fall, da brauchen wir keine weitere Gefahrenquelle, wenn wir sie vermeiden können. Oder sollte ich besser von einer weiteren “Büchse der Pandora” schreiben, die besser geschlossen bleibt? – Das käme aufs selbe heraus.